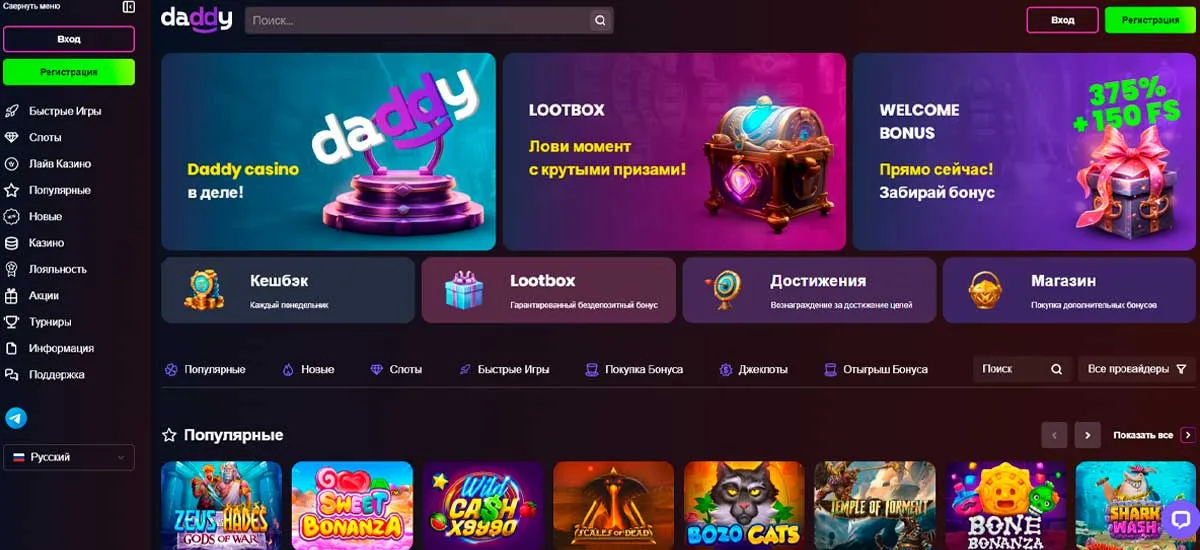

В сегодняшнем обзоре мы расскажем про новое заведение Daddy casino, о его особенностях. Сайт вас встретит в фирменной цветовой палитре с уникальным знаком на главном экране «Daddy», темный интерфейс не напрягает глаза от длительной игры. Интерфейс сделан таким образом чтобы игроки ПК версии и мобильной не испытывали трудностей при выборе онлайн слота либо Live игры!

Крутой приветственный бонус 375% + 150 фриспинов от Дэдди казино уже ждет вас в личном кабинете! Рабочее зеркало на 13.03.2024 Интерфейс сделан таким образом чтобы игроки ПК версии и мобильной не испытывали трудностей при выборе онлайн слота либо Live игры!

Рабочее зеркало Daddy casino на официальный сайт Дэдди казино

В обзоре Дэдди казино мы подробно рассмотрим особенности официального сайта, мобильных приложений, бонусной программы и другие важные моменты, чтобы помочь вам решить, стоит ли играть здесь.

Дэдди казино зеркало – это точная копия официального сайта с тем же функционалом и данными игроков. Казино Дэдди создается для обхода блокировок основного ресурса.

Использование копий Daddy казино полностью безопасно для игроков. Все данные и деньги сохраняются, так как зеркало подключено к единой платформе.

Ссылку на казино Дэдди рекомендуется брать только на проверенных информационных ресурсах об азартных играх, таких как наш сайт. Мы размещаем рабочие ссылки для гарантированного доступа на официальный сайт.

Также пользователи могут воспользоваться ссылками на тематических сайтах, либо в социальных сетях таких как Telegram, Instagram либо Twitter. Также можно воспользоваться службой поддержки для получения актуального рабочего зеркала.